Содержание

Информация — ценный ресурс. Бизнесу нужно понимать, что происходит у конкурентов, какие товары растут в спросе и как меняется рынок изо дня в день. Но вручную отследить все изменения невозможно: источников слишком много. Парсеры сайтов за минуты собирают нужную информацию, обрабатывают ее и превращают в основу для принятия решений.

Что такое парсер и парсинг сайтов

Парсер — это программа, скрипт или онлайн-сервис, который выполняет извлечение информации из открытых источников в интернете. Это инструмент для анализа структуры веб-ресурса и автоматического сбора данных с него. Он читает код страницы, определяет нужные элементы и сохраняет их в удобном виде, например в таблице или CSV-файле.

Парсинг сайтов — процесс обработки содержимого веб-страниц. Он включает чтение и интерпретацию html-структуры, выделение ключевой информации (цены, тексты, ссылки, изображения, контакты) и преобразование ее в пригодный для анализа формат.

Плюсы использования парсеров:

- высокая скорость программного извлечения данных;

- отсутствие человеческих ошибок;

- возможность анализа структуры html-документа в реальном времени;

- гибкая настройка синтаксического разбора текста и форматов выгрузки.

Как используют парсеры

Компании ежедневно работают с огромными объемами информации, и вручную обрабатывать ее слишком долго. На помощь приходят автоматизированное извлечение и анализ веб-страниц.

Основные сферы применения парсеров:

- Мониторинг компаний и цен. Парсинг сайтов конкурентов позволяет регулярно отслеживать ассортимент, стоимость товаров, наличие акций и скидок.

- SEO-аудит и технический анализ. Парсер позволяет выполнять сканирование страницы, выявлять ошибки в их структуре, проверять метатеги, заголовки, ссылки, проводить синтаксический анализ и формировать базу данных для оптимизации.

- Маркетинговые исследования. При помощи скрипта парсинга компании собирают отзывы, рейтинги, упоминания брендов. После обработки полученной информации можно формировать или изменять маркетинговую стратегию.

- Наполнение интернет-витрин и каталогов. Система извлекает сведения со страниц — названия, цены, описания, изображения — и преобразует их в готовый формат для загрузки.

- Финансовая и отраслевая аналитика. С помощью программного сканера можно собирать сведения с отраслевых порталов или маркетплейсов, чтобы оценивать тенденции и строить прогнозы.

Законность парсинга в России

Российское законодательство не запрещает извлечение сведений из открытого источника. Напротив, Конституция РФ (ст. 29) закрепляет право каждого свободно искать и получать их любым законным способом. Но свобода поиска информации на сайте не безгранична. Есть четыре зоны риска, из-за которых обработка содержимого веб-ресурса может стать нарушением закона.

- Авторское право. Парсинг становится незаконным, если копируется охраняемый контент, например фотографии. Допустимо собирать только факты: цену, артикул, наличие товара. Использование их для анализа безопасно, а вот перепубликация — нарушение прав владельца базы данных (ст. 1334 ГК РФ).

- Неправомерный доступ и нагрузка на сервер. Если программа пытается обойти защиту, подбирать пароли или отправляет тысячи запросов в секунду, действия могут трактоваться как неправомерный доступ или создание угрозы функционированию ресурса.

- Базы персональных данных (закон 152-ФЗ). С 2025 года усилился контроль над хранением и обработкой перссведений. Любой скрипт для парсинга для сбора личных и контактных данных без согласия нарушает закон и может привести к штрафам до 18 млн ₽.

- Недобросовестная конкуренция. Парсинг может быть признан злоупотреблением правом, если используется с целью нанести вред конкуренту, например для создания клона сайта или срыва работы сервера.

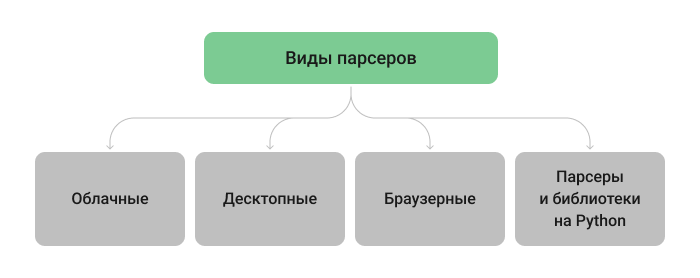

Виды парсеров

Программа-парсер помогает автоматизировать сбор сведений с веб-страницы и заменить ручной поиск на точные выгрузки. В зависимости от задач и уровня подготовки можно выбрать облачный сервис, десктопное решение, браузерное расширение или скрипт на Python.

Облачные парсеры

Облачные парсеры — это онлайн-сервисы, которые выполняют сбор сведений без установки на компьютер. Такая программа для парсинга сайтов работает полностью в облаке: пользователь задает сценарий или загружает шаблон, а сервис выполняет сканирование, извлечение ссылок из страниц, обработку текстовых данных.

Плюсы:

- Не нужно ставить программу, все работает в браузере.

- Быстрый старт: настройка занимает минуты.

- Результаты удобно выгружать в CSV, JSON, таблицы.

- Можно устанавливать расписание — тогда сведения обновляются автоматически.

- Обычно есть готовые интеграции с BI и CRM.

Минусы:

- Есть лимиты по объему, количеству задач и скорости.

- Для динамических страниц часто требуется JS-рендер, который быстрее расходует лимиты.

- Если сервис тормозит или «падает», сбор тоже замедляется.

Десктопные парсеры

Это программы для парсинга, которые устанавливаются на компьютер и работают локально. Они позволяют настраивать скрипты, выбирать источники, менять скорость сканирования ресурса и обработки данных.

Плюсы:

- Работают быстро и стабильно, независимо от внешнего сервиса.

- Поддерживают сложные веб-ресурсы.

- Можно подключать прокси и сохранять сценарии для повторного запуска.

- Большинство парсеров умеют выгружать результаты в CSV, Excel.

Минусы:

- Нужно устанавливать программу и следить за обновлениями.

- Производительность зависит от мощности компьютера.

- Часто разовый платеж больше цены подписки, но в долгосрочном использовании это может быть выгоднее.

- Нет централизованного хранения полученных данных.

Браузерные расширения

Это дополнения для Chrome, Firefox или других браузеров. Они быстро собирают нужные данные со страницы без установки отдельного софта. Подходят, если нужно извлечь небольшие объемы информации, например таблицу цен, список товаров или контакты.

Плюсы:

- Расширение работает сразу после добавления в браузер.

- Простой интерфейс, выделение данных прямо на странице.

- Можно быстро выгружать результаты в Excel, CSV или Google Sheets.

Минусы:

- Браузер не рассчитан на длительное и массовое сканирование сайтов — он может зависнуть или выдать ошибку.

- Расширение работает, пока открыта вкладка.

- Память и скорость ограничены ресурсами компьютера, чувствительны к изменениям верстки.

Парсеры и библиотеки на Python

Python — универсальный инструмент для тех, кто хочет полностью контролировать процесс. Скрипты позволяют задавать правила, как парсить сайты, автоматизировать сканирование, извлечение и обработку сведений в нужном формате.

Python используют для сбора таблиц, отзывов, ссылок и цен. Скрипты позволяют анализировать структуру страницы, проверять метатеги и обновлять информацию по расписанию.

Плюсы:

- Можно гибко настраивать процесс под любые веб-ресурсы.

- Легко автоматизировать сбор и анализ информации.

- Есть множество готовых решений и библиотек.

- Подходит для масштабных проектов и постоянных выгрузок.

Минусы:

- Требуются навыки программирования и поддержка кода.

- Сложнее в настройке, чем облачные сервисы.

Как выбрать парсер: чек-лист и советы

Чтобы понять, как спарсить сайт быстро и без ошибок, важно выбрать подходящий инструмент. Универсального решения нет: многое зависит от целей, объема выгрузки и бюджета. Ниже — короткий гайд, который поможет определиться с выбором программы-парсера сайта.

- Определите цель. Зачем нужен парсинг: собрать цены конкурентов, сделать SEO-аудит, обновить каталог или провести маркетинговый анализ. Чем точнее цель, тем проще выбрать инструмент.

- Оцените объем, сложность и частоту.

- Несколько страниц (разовая задача): подойдет простое браузерное расширение.

- Много страниц, типовые и повторяющиеся задачи: оптимальны специализированные парсеры (например, Screaming Frog для SEO-аудитов или A-Парсер для работы с большими массивами данных). Они эффективно обрабатывают тысячи страниц и экономят время, если данные нужно собирать регулярно.

- Сложные и кастомные задачи, полный контроль над логикой: скрипты на Python (с использованием прокси, систем обхода капчи и библиотек вроде Selenium). Это гибкое решение, но требующее технических знаний и времени на поддержку.

- Учтите удобство и поддержку. Обратите внимание на интерфейс, наличие шаблонов и инструкций. Хорошо, когда есть техподдержка, — это сэкономит время при настройке.

- Проверяйте экспорт и совместимость. Хороший парсер должен выгружать содержимое в нужный формат — CSV, XLSX, JSON. Это упрощает дальнейший анализ и работу с BI-системами.

- Смотрите на ограничения и безопасность. Уточните лимиты по страницам, скорость работы и доступ к API. Убедитесь, что инструмент не будет нарушать закон о персданных и правила веб-ресурса.

- Протестируйте перед покупкой. Почти у всех сервисов есть демодоступ или бесплатный тариф. Попробуйте спарсить несколько страниц и оцените результат.

Топ программ для парсинга: сравнительная таблица

Когда вы знаете, как спарсить данные с сайта, осталось выбрать инструмент. Мы собрали список лучших парсеров, с которыми вы сможете быстро извлекать нужное, анализировать структуру страниц и автоматизировать обновления информации.

| Название | Тип | Назначение | Основные возможности | Цена (октябрь 2025) |

|---|---|---|---|---|

| A-Parser | Десктоп | Массовый парсинг поисковиков, маркетплейсов | Профессиональная программа с поддержкой прокси, API и кастомных шаблонов | от $179 — единоразовый платёж |

| Bright Data | Облачный | Масштабный сбор данных, обход капч | Собственная сеть прокси, автоматическое решение капч, высокая масштабируемость | от $1–1,5 за 1000 запросов |

| Octoparse | Десктоп + облако | No-code парсинг для маркетологов и аналитиков | Интерфейс без кода, готовые шаблоны | от $69/мес, есть бесплатный план |

| Apify | Облачный | Кастомные сценарии и автоматизация парсинга | Готовые акторы, возможность писать свои скрипты на JS, встроенный пул прокси | от $39/мес, есть бесплатный план |

| ParseHub | Десктоп | Визуальный парсинг сложных сайтов | Поддержка AJAX, конструктор без кода | от $189/мес, есть бесплатный план |

| WebScraper.io | Расширение Chrome + облако | Быстрый парсинг сайтов без кода | Настройка в браузере, ограниченное облачное хранение | от $50/мес (облако), есть бесплатный план |

| Data Miner | Расширение Chrome | Парсинг списков прямо из браузера | Простое извлечение таблиц и списков в CSV, готовые шаблоны | от $19,99/мес, есть бесплатный план |

| Screaming Frog SEO Spider | Десктоп | SEO-аудиты сайтов | Проверка внутренней оптимизации, мета-тегов, дублей, редиректов, статс-кодов, краулинг страниц | от $ 235/год, есть бесплатная версия (парсинг до 500 URL без лицензии, подойдет для маленьких сайтов) |

| Netpeak Spider | Десктоп | SEO-аудиты и технический анализ | Проверка внутренней оптимизации, мета-тегов, дублей, редиректов, статс-кодов, краулинг страниц | от $19/мес, есть бесплатная версия |

Все для трафика под ключ

От настройки до роста трафика: делаем сайт заметным и приводим заинтересованных посетителей.

Защита от парсинга и обход ограничений

Большинство веб-ресурсов стараются ограничить автоматический сбор содержимого, чтобы защитить контент, снизить нагрузку на сервер и предотвратить копирование. Поэтому любая программа-парсер сталкивается с разными барьерами — от технических до правовых.

Чаще всего владельцы ресурсов применяют robots.txt, чтобы задать правила сканирования страниц, капчу для проверки активности пользователей, rate limiting для ограничения количества запросов и динамическую загрузку через JavaScript, которая усложняет извлечение информации.

Чтобы обойти такие ограничения, нужно действовать аккуратно:

- Учитывать (или игнорировать) файлы robots.txt и meta-атрибуты. Владельцы домена могут указывать правила сканирования не только в файле robots.txt, но и через HTTP-заголовки или атрибуты meta robots. Парсер можно настроить так, чтобы он следовал этим правилам или, в определенных ситуациях, игнорировал их, если это необходимо и этично.

- Настраивать интервалы между запросами. Если программа обращается к ресурсу слишком часто, это создает избыточную нагрузку (и может даже «положить» сайт), что почти гарантированно приводит к блокировке IP. Лучше выдерживать между запросами паузу 1–3 секунды, а при большом объеме данных — 5–10 секунд.

- Использовать ротацию IP и пользовательских агентов (User-Agent). При большом объеме выгрузки лучше распределять трафик между несколькими IP-адресами через прокси, чтобы не вызывать подозрение у системы защиты. Дополнительно рекомендуется менять User-Agent в настройках парсера, имитируя разные браузеры. Для легитимного бизнес-парсинга иногда можно договориться с владельцем сайта о добавлении вашего IP в белый список или настройке специального User-Agent, для которого системы защиты не будут срабатывать.

- Работать с динамическим контентом. Если ресурс подгружает информацию через JavaScript, стандартный парсер может не увидеть нужные элементы. Для самописных решений применяются библиотеки, например Selenium или Playwright, которые имитируют работу браузера. Многие продвинутые готовые парсеры также могут обрабатывать такой контент, хотя для этого может потребоваться активировать соответствующую настройку в их опциях.

FAQ о парсинге

Кратко о главном

- Парсеры автоматизируют сбор данных, упрощают анализ и позволяют работать с большими объемами информации без ручного труда.

- Парсинг можно законно использовать только при обработке открытых сведений. Нельзя извлекать персональные данные и охраняемый контент.

- Есть облачные, десктопные, браузерные парсеры, скрипты и библиотеки на Python — они различаются способом работы, возможностями и уровнем автоматизации.

- Эффективность инструмента зависит от целей: важно учитывать структуру страницы, формат содержимого, требования к обновлению.

Читайте лучшие материалы первыми

Подписавшись на рассылку, вы соглашаетесь с Политикой Конфиденциальности.